Ai分享

DeepSeek V3.2爆火, Agentic性能暴涨40%解密

2025-12-16

【新智元导读】DeepSeek V3.2的Agentic本事大增,离不开这项要津机制:Interleaved Thinking(交错念念维链)。Interleaved Thinking风靡开源社区背后,离不开另一家中国公司的鼓吹。

大模子的「忘记症」,早该治治了!

当你试图用现在开头进的大模子帮你完成一个复杂的长假运筹帷幄,比如「带全家老少去云南玩七天」时,频频很可能会碰到一个令东说念主崩溃的时刻:

开头,这位「导游」进展得极其靠谱,分析得头头是说念。

它铭刻你说的每一句条款,帮你运筹帷幄了昆明到大理的阶梯,致使贴心肠消亡了旅客太多的网红店。

但跟着对话进行到第十轮,你们为了选旅馆修改了五次有运筹帷幄,又为了某顿晚餐争论了半天后,它倏得「失智」了。

它运转忘记你一运转强调了无数遍的死敕令:「带着80岁的奶奶,十足弗成安排爬山和剧烈通顺」。

在最新的行程表里,它果然津津隽永地建议:「第四天黎明:全家早起徒步攀缘玉龙雪山,观赏日照金山,全程耗时4小时……」

图片由Nano Banana Pro生成

在AI工程界,这种气候有一个术语:状况漂移(State Drift)。

这并非模子「变笨」了,而是咱们让它念念考的样式错了。

为了拯救这种「忘记症」,Anthropic Claude、OpenAI GPT-OSS、MiniMax M2、Kimi K2 Thinking等国表里各大模子都殊途同归地遴选了并吞项时期:一边念念考,一边用器具(Thinking in Tool-Use)。

DeepSeek: Thinking in Tool-Use

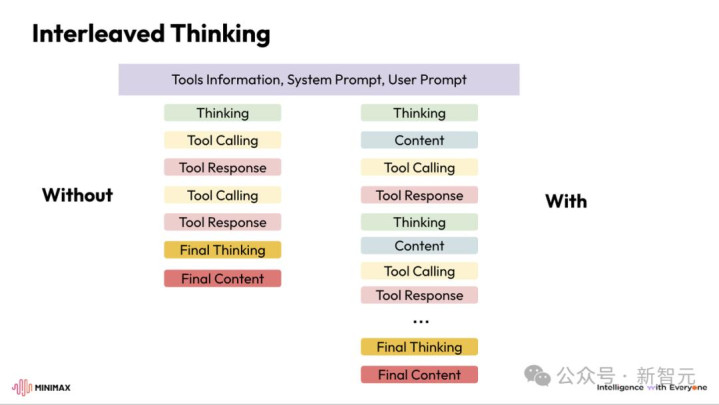

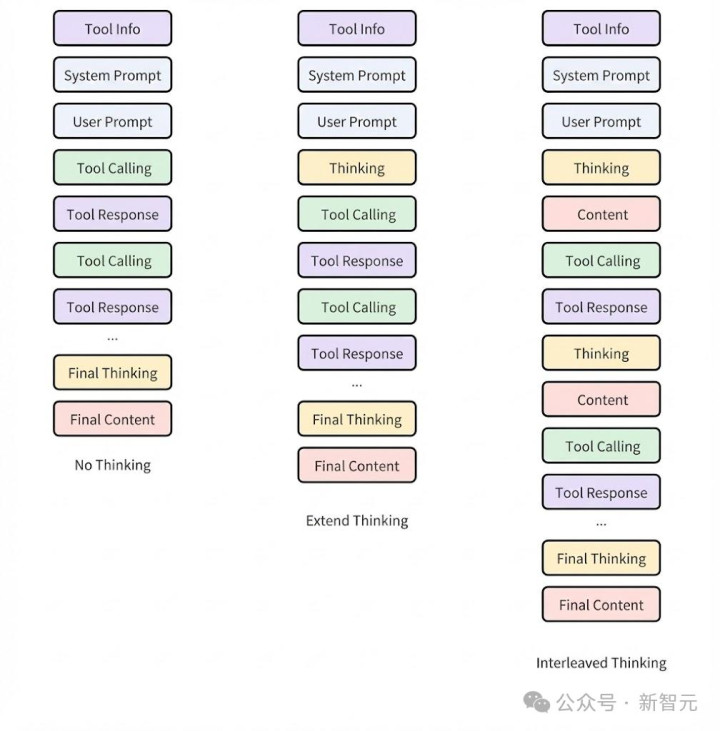

MiniMax等部分厂商也将其称作Interleaved Thinking(交错念念维链),从暗示图即可看出,二者实质上是等价的。这是一个更靠近时期的称号。

Minimax: Interleaved Thinking(交错念念维链)

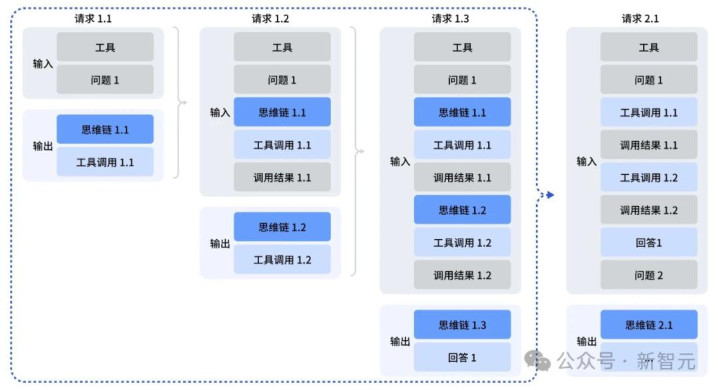

如图所示,交错念念维链即模子在推理(thinking)和器具调用(action)之间往返轮换,并执续保留和复用每一轮的推理状况,从而达成平定、可积贮的长程运筹帷幄。

崩溃的ReAct

与「隐式推理」的吊问

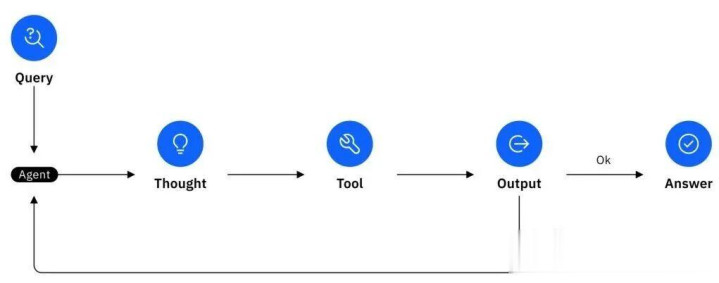

要意会交错念念维链为什么是「神技」,咱们得先望望它的前任——早期的ReAct(Reasoning+Acting)范式是奈何遇到瓶颈的。

ReAct历程暗示图

在很长一段时候里,咱们构建AI Agent的逻辑相配线性:不雅察->念念考->行为。

这看起来很允洽直观,但在本质的工程达成(如OpenAI的Function Calling(函数调用))中,这个过程频频被简化成了「模子径直输出器具调用指示」。

问题就出在这里。

模子在输出Action(比如「读取文献A」)的那一刻,它的「脑子」是知晓的。

但当器具实践收场,复返了数千行的代码或网页内容后,模子参加下一轮生成时,它靠近着遍及的环境扰动。

联想一下,你是一个法子员,每写一瞥代码,就有东说念主把你打晕,消灭你的短期追想,然后把刚才的运行日记扔给你,让你连接写。

由于穷乏显式的、畅达的念念维纪录,模子很容易被复杂的器具复返死心带偏。

它可能会被报错信息蛊惑提防力,从而忘记了原来的长期运筹帷幄。

这便是「隐式推理」的吊问。

模子的念念考过程荫藏在权重里,一朝被打断(Turn-based interaction),这些念念维火花就九霄了。

交错念念维链:给Agent装上「海马体」

MiniMax的研发团队在确立M2模子时,机敏地捕捉到了这个痛点。

Agent需要的不仅仅更长的险峻文窗口,更是一种显式的、可积贮的念念考状况。

这便是交错念念维链。

它的责任流变成了:念念考->行为->不雅察->念念考->行为->不雅察...

在这个闭环中,「念念考」不再是无可不可的点缀,而是必须被纪录下来的状况。

在每一次调用器具之前,模子必须先输出一段被包裹在reasoning_details(或肖似的tag)中的天然谈话。

这段笔墨不仅仅给用户看的,亦然给异日的我方看的,让我方知说念来时路。

为什么它能带来40%的性能暴涨?

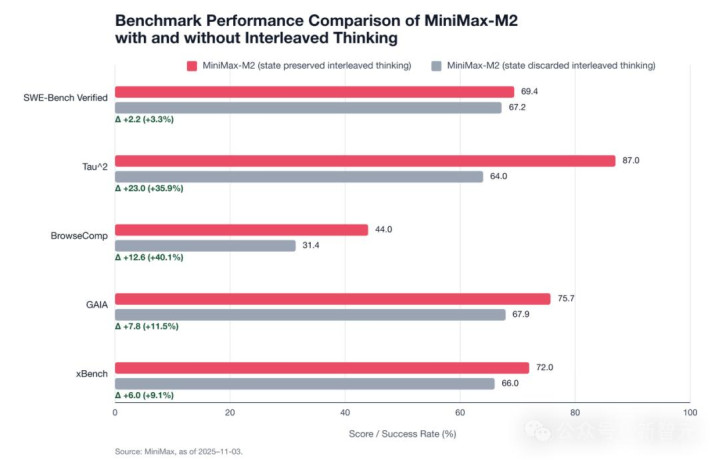

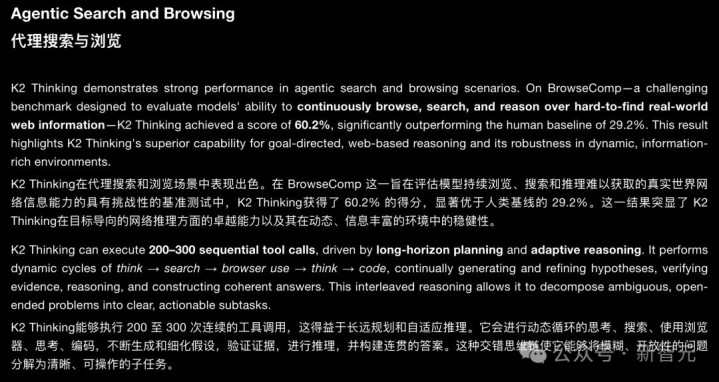

MiniMax M2的发布数据中,有一组数据有劲诠释了这一机制的成果。

在惯例的SWE-Bench Verified(软件工程)榜单上,开启交错念念维链带来了3.3%的晋升(从67.2升至69.4)。这个晋厌世然可以,但还算温顺。

相关词,在BrowseComp(网页浏览任务)上,晋升幅度达到了惊东说念主的40%(从31.4飙升至44.0);在Tau²这种复杂推理任务上,晋升了36%。

为什么会有这种遍及的各异?这涉及了Agent时期的深层旨趣。

MiniMax的后测验团队在时期复盘中指出:Agent的中枢挑战,在于抗拒环境的扰动。

低扰动环境(SWE-Bench):代码环境相对洁白,报错信息频繁是详情味的。模子即使稍稍「跑神」,也能证实明确的Traceback找回逻辑。

高扰动环境(BrowseComp):真的的互联网充满了杂音。告白、无关的侧边栏、复杂的DOM结构、致使是失误的搜索死心。在传统的ReAct模式下,模子极易被这些杂音带偏。

交错念念维链本质上充任了一个「滤波器」。

模子通过显式的念念考,在袭取到交加的网页信息后,先进行一轮「信息清洗」和「逻辑校准」:「我刚才搜索了X,死心里有好多无关信息,唯一第三段是我需要的,接下来我应该证实这个陈迹去查Y。」

这种「走一步、停驻来想一步、再走下一步」的机制,极地面增强了模子的健壮性。

它将一个长达数十步的脆弱链路,拆解成了一个个平定的「原子化」念念考闭环。

泛化的实质:从「器具」到「轨迹」

Agent的泛化,究竟是在泛化什么?

早期业界普遍觉得,只消让模子学会使用更多的器具(Scaling Tools),Agent就泛化了。

但MiniMax团队发现,这仅仅「输入层」的泛化。

真的的泛化,是对任务轨迹中整个可能扰动的恰当本事。

一个模子可能在Claude Code这种脚手架里进展完好,但换到Cline或者敕令行里就一塌婉曲。

因为不同的环境、不同的请示词结构、不同的器具复返表情,都会对模子的推理轨迹产生扰动。

交错念念维链让模子领有了自我修正的本事。

通过在每一步都保留推理内容,模子本质上是在不休地与环境进行「对皆」。

即使换了一个目生的IDE环境,只消「念念考-行为」的闭环还在,模子就能通过显式的逻辑推理来恰当新环境,而不是依赖死记硬背的请示词模板。

这亦然为什么MiniMax M2好像在xBench、GAIA等多个异构榜单上全面吐花的时期根源。

MiniMax的「基建狂魔」之路

时期旨趣讲知晓了,但落地却是另一趟事。

在M2发布之初,MiniMax靠近着一个狼狈的场所:行业的基础门径严重滞后。

天然Anthropic最早建议了Extended Thinking的意见,但由于其闭源特质,社区并未酿成合资表率。

绝大大批开源器具(如LangChain、LlamaIndex)和中间件,都是基于OpenAI的Chat Completion API构建的。

而这个表率API里,根底莫得方位放「念念考过程」。

这就导致了一个凄惨性的后果:用户在使用M2时,民俗性地把API复返的reasoning_details字段当成垃圾信息丢掉了。

模子明明在念念考,但它的追想被不测中切除了。这径直导致了模子性能的血崩。

面对这个问题,MiniMax言之成理,运转我方入辖下手修路。

在当年的一段时候里,MiniMax的工程师们化身开源社区的「包领班」,向全球主流的Agent确立器具和平台发起了密集的PR(Pull Request,合并申请)攻势。

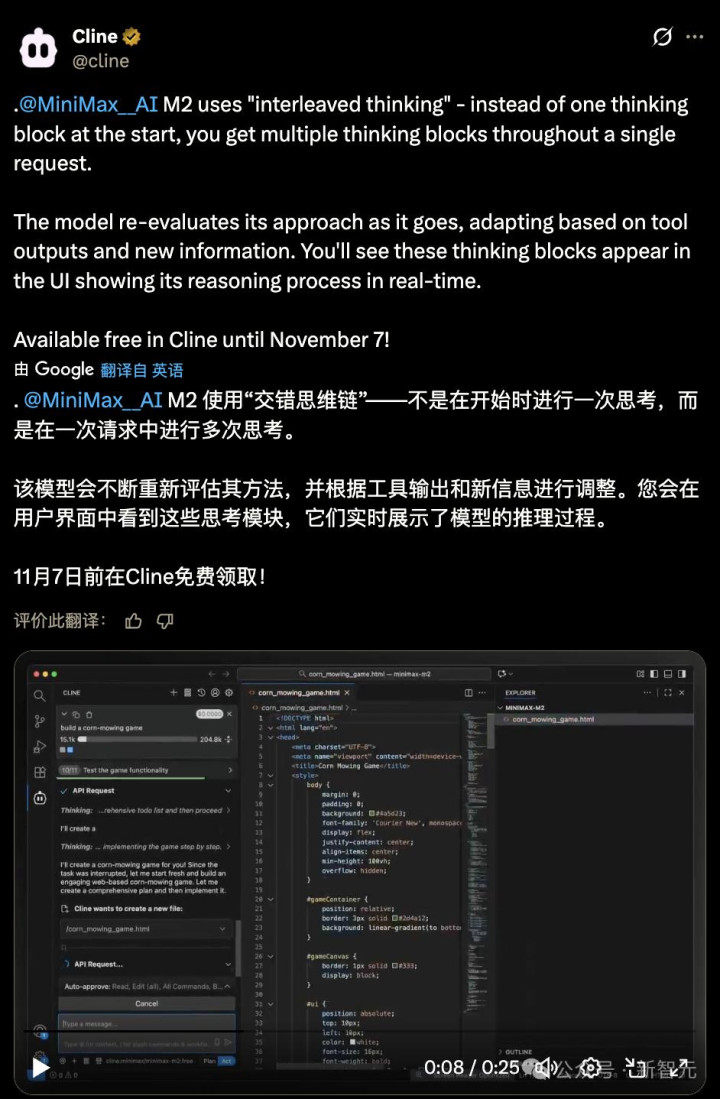

Cline:这是VS Code上最火的AI编程插件之一。MiniMax团队与其精良互助,修改了底层的音讯处理逻辑,确保在IDE的对话历史中,不仅保留代码,还保留模子的念念考过程。这径直让M2在Cline里的进展从「不可用」变成了「丝滑」。

Kilo Code:针对这个新兴的云表IDE,MiniMax提交了代码,优化了环境细节与器具死心的合并逻辑,惩办了多轮对话中状况丢失的问题。

OpenRouter / Ollama:通过与这些模子托管平台的互助,MiniMax鼓吹了API左券的升级,让reasoning_details字段从一个「独到左券」安逸变成了事实上的表率彭胀。

正风靡云蒸地进行中的AWS re:Invent 2025大会上,MiniMax也获取了亚马逊的认同。

AWS re:Invent 2025大会上,AWS CEO晓谕Amazon Bedrock模子库迎来扩容,MiniMax M2算作中国模子代表在列

硬汉所见略同

DeepSeek V3.2和Kimi K2 Thinking的入局

DeepSeek V3.2和Kimi K2 Thinking的发布,宣告了这条路负责成为了通往异日的骨干说念。

最近激发颤动的DeepSeek V3.2,其中枢特质之一「Thinking in Tool-Use」(使用器具中念念考),在实质上与MiniMax倡导的交错念念维链是完全一致的。

DeepSeek的时期文档中明确指出:模子在调用器具时,会保执念念维链的畅达性,直到收到新的用户音讯才会重置。

这种遐想逻辑与MiniMax M2强调的「多轮交互中保眷顾念考状况」如出一辙。

Kimi K2 Thinking也支柱了交错念念维链,进而得以Agentic本事上突飞大进。

天然两家在具体的API字段定名上可能略有不同(MiniMax使用reasoning_details,DeepSeek使用reasoning_content,Anthropic使用thinking_blocks等),但在系统遐想玄学上,环球也曾达成了一致:显式的、交错的、执久化的念念考,是智能体进化的必经之路。

OpenAI的盘问标明,AI的性能不仅革职参数目的Scaling Law,也革职Test-Time Compute(测试时绸缪)的Scaling Law。

它正在从阿谁只会证实请示词模板机械实践敕令的「复读机」(Copilot),进化为好像在复杂的真的天下中,面对无数未知的扰动和杂音,依然好像停驻来念念考、自我修正、并坚强地实践长链路任务的「念念想者」(Autopilot)。

而这,已成行业的共鸣。